Malam itu, dalam keheningan yang terdengar hanya dentingan keyboard dan desiran kipas pendingin laptop, saya mencoba mengeksplorasi Artificial Intelligence (AI) dalam musik. Desktop memancarkan cahaya kebiruan, menampilkan antarmuka SUNO AI, sebuah perangkat lunak yang konon mampu menciptakan musik hanya dari teks yang kita berikan.

Saya mencoba mengusir keraguan yang mengendap di benak saya: bisakah kecerdasan buatan benar-benar menggantikan kreativitas manusia? Bisakah ia menciptakan melodi yang memiliki emosi, sejarah, dan makna, seperti yang diciptakan oleh seorang komposer yang menghabiskan bertahun-tahun mengasah kepekaannya terhadap nada dan harmoni?

Pertanyaan ini bukan hanya refleksi pribadi saya, tetapi juga telah menjadi debat yang berkembang dalam dunia musik dan teknologi. Menurut Boden (2004), kreativitas manusia bukan sekadar kombinasi ide yang sudah ada, tetapi juga melibatkan intuisi, perasaan, dan pengalaman yang tidak bisa direduksi menjadi pola data. AI, dengan segala kemampuannya, tetap bekerja dengan mengidentifikasi pola dan mengulanginya dalam bentuk baru, tetapi apakah itu cukup untuk menggantikan kejeniusan seorang seniman?

Ada sesuatu yang menggelitik pikiran saya. Musik selama ini adalah dunia yang penuh sentuhan manusiawi, tempat emosi, pengalaman, dan ekspresi bercampur dalam harmoni yang tak bisa direduksi menjadi sekadar angka dan algoritma. Saya membayangkan Beethoven yang kehilangan pendengarannya tetapi masih bisa menggubah simfoni yang abadi, mengandalkan kepekaan batinnya terhadap harmoni yang ia ciptakan di dalam pikirannya sendiri (Sacks, 2007). Begitu pula Freddie Mercury yang menyusun lirik dengan ketelitian ekstrem, memastikan bahwa setiap kata memiliki dampak emosional yang tepat, karena ia tahu bahwa musik bukan hanya tentang bunyi, tetapi juga tentang bagaimana bunyi itu berbicara kepada hati manusia (Mazzola et al., 2011).

AI dan Komposisi

Meskipun AI dapat meniru pola komposisi musik yang dibuat manusia, dalam pandangan Cook (2019), AI tidak dapat mengalami penderitaan, kebahagiaan, atau nostalgia yang menginspirasi karya seni yang sesungguhnya. Ini berarti, seberapa pun canggihnya AI, tetap akan kesulitan menciptakan sesuatu yang benar-benar otentik dan berakar pada pengalaman manusia.

Namun, di sisi lain, rasa penasaran saya mengalahkan keraguan itu. Saya ingin tahu bagaimana teknologi ini bekerja, bagaimana ia memproses kata-kata menjadi nada, bagaimana ia mencoba memahami sesuatu yang selama ini kita anggap sebagai ekspresi paling manusiawi: musik.

Saya menggerakkan kursor ke dalam kolom teks di layar, mulai mengetik beberapa baris lirik dalam bahasa Madura—bahasa yang saya dengar sejak kecil, bahasa yang membawa ingatan tentang rumah, keluarga, dan tradisi yang telah diwariskan selama berabad-abad.

Bahasa dan musik memiliki hubungan kognitif yang erat—keduanya merupakan sistem komunikasi yang melibatkan pola ritme, intonasi, dan ekspresi (Menurut Patel, 2010). Jika AI bisa memahami bahasa dengan baik, mungkinkah juga bisa memahami emosi dan identitas budaya yang melekat dalam musik yang berbasis bahasa daerah seperti Madura?

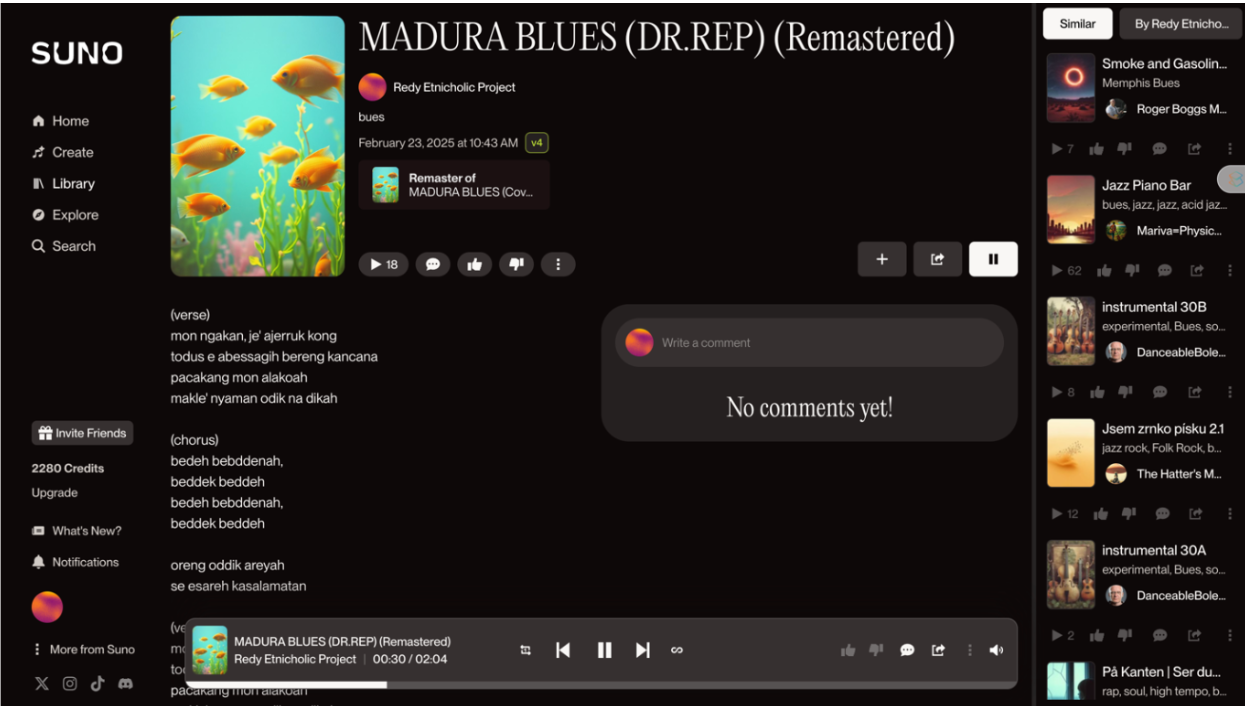

Setelah memastikan lirik sudah siap, saya mengklik tombol Generate. Seketika, layar menampilkan proses pemrosesan data. Sebuah bar kecil mulai bergerak perlahan, maju sedikit demi sedikit, seperti denyut nadi yang menghidupkan mesin di balik layar.

Saya menunggu, mencoba memahami apa yang sebenarnya sedang terjadi di balik proses ini. Di dunia yang tak terlihat, algoritma mulai bekerja. Ia membaca teks saya, menganalisis pola linguistiknya, mencocokkannya dengan dataset yang telah ia pelajari, lalu menghubungkannya dengan struktur musik yang sesuai.

Proses ini dikenal sebagai “computational music generation,” di mana AI bekerja dengan menguraikan pola-pola musik dari dataset yang telah dipelajari sebelumnya, lalu merekonstruksi pola tersebut untuk menciptakan musik baru (Herremans et al., 2017). Namun, AI tidak benar-benar “berkreasi” seperti manusia—AI hanya meniru, mencocokkan, dan menggabungkan elemen-elemen yang telah ada dalam sistemnya.

Saya membayangkan bagaimana kode-kode komputer menelusuri jutaan referensi musik yang tersimpan dalam sistem, mencari pola harmoni yang sesuai, memilih instrumen yang tepat, dan menyusun melodi berdasarkan analisis struktur bahasa.

Cope (2001) menerangkan bahwa AI dalam musik bekerja dengan prinsip “pattern matching,” yaitu mendeteksi pola komposisi yang umum dalam dataset, kemudian menciptakan komposisi baru berdasarkan pola yang telah dikenali. Proses ini mirip dengan cara manusia belajar musik secara teori, tetapi tanpa intuisi dan pengalaman emosional yang membentuk keunikan ekspresi musik manusia.

Namun, tidak seperti seorang komposer manusia yang bekerja dengan intuisi dan perasaan, AI hanya memahami pola-pola statistik. AI tidak tahu bagaimana perasaan seseorang ketika mendengar nada tertentu. AI tidak tahu bagaimana suara hujan bisa membuat seseorang bernostalgia, atau bagaimana suara gending gamelan bisa membawa seseorang ke masa kecilnya di kampung halaman.

Emosi dalam musik tidak hanya berasal dari struktur nada dan harmoni, tetapi juga dari pengalaman subjektif dan asosiasi budaya yang melekat pada setiap individu (Patel, 2010). Inilah yang tidak dimiliki oleh AI—kemampuan untuk merasakan dan menghubungkan pengalaman manusia dengan bunyi yang dihasilkan.

Akhirnya, setelah beberapa detik yang terasa panjang, sebuah lagu mulai dimainkan. Saya memejamkan mata, membiarkan telinga saya menangkap nada pertama. Ada ketukan, ada melodi yang mengalir, tetapi ada sesuatu yang terasa asing.

Saya membuka mata dan menatap layar. Lagu ini terdengar menarik, tetapi ada sesuatu yang tidak sepenuhnya “Madura” dalam lagu ini. Pertama, spelling dan pelafalan yang tidak akurat. Saya memutar ulang bagian chorus dan verse beberapa kali. Ada yang aneh dalam cara AI menyanyikan lirik saya.

Saya memperhatikan ketidaktepatan dalam pengucapan beberapa kata, terutama dalam fonetik khas bahasa Madura. Misalnya, kata “ajerrukong“, yang dalam bahasa Madura berarti duduk seperti posisi nongkrong tanpa harus duduk di tanah, terdengar melenceng dari pelafalan aslinya.

Tidak hanya itu, beberapa suku kata terdengar terpotong atau diucapkan dengan intonasi yang berbeda dari cara orang Madura biasa melafalkannya. Kondisi ini sejalan dengan temuan penelitian Besacier et al. (2014) bahwa tantangan utama dalam pengenalan suara berbasis AI adalah keterbatasan dataset yang digunakan dalam pelatihan model, terutama untuk bahasa yang kurang terdokumentasi secara global. Dalam konteks ini, bahasa Madura bukan hanya kurang terdokumentasi dalam format teks, tetapi juga dalam format audio yang digunakan sebagai basis pelatihan AI.

AI dalam pemrosesan bahasa sering kali mengalami “bias linguistik,” di mana sistem lebih akurat dalam mengenali bahasa dengan representasi data yang lebih luas (Adams et al., 2019). Ini berarti, bahasa-bahasa daerah seperti Madura, yang tidak memiliki banyak rekaman fonetik dalam dataset AI global, akan sulit dikenali dengan presisi yang sama seperti bahasa Inggris atau Spanyol.

Hal ini masuk akal. AI dilatih menggunakan korpus data musik global, yang sebagian besar berasal dari bahasa Inggris atau bahasa internasional lainnya. Bahasa seperti Madura, yang tidak banyak terdokumentasi dalam sistem AI, akan sulit dikenali dengan akurat oleh algoritma ini.

Timbul pertanyaan, bagaimana AI bisa dilatih lebih lanjut agar mampu memahami fonetik bahasa daerah dengan lebih baik? Van den Oord et al. (2016) menawarkan solusi dengan memperkaya dataset AI dengan variasi linguistik yang lebih luas, termasuk menambahkan rekaman audio dari penutur asli yang dapat membantu model dalam menangkap keunikan fonetik bahasa tertentu.

Kedua, kurangnya fleksibilitas dalam ritme dan intonasi. Saya mendengarkan bagian refrain sekali lagi. Saya berharap mendengar dinamika yang lebih bebas, perubahan ritme yang lebih alami, atau sedikit improvisasi yang membuat musik terasa lebih manusiawi. Ternyata, AI tidak memiliki fleksibilitas dalam mengatur ritme dan intonasi. Musik ini terdengar terlalu terstruktur, terlalu rapi, terlalu terprediksi.

Hal ini karena AI dalam musik bekerja dengan pendekatan prediktif berbasis pola statistik, yang cenderung menghasilkan struktur musik yang seragam dan terkontrol (Dannenberg, 2017). Sementara itu, musik manusiawi mengandalkan spontanitas, improvisasi, dan perubahan ekspresi yang tidak selalu mengikuti pola yang terstandarisasi.

Dalam musik tradisional Madura, terdapat naik-turun nada yang khas, ekspresi vokal yang mengikuti aliran emosi penyanyi. Kadang-kadang, seorang penyanyi bisa menarik suaranya lebih panjang di bagian tertentu, atau mempercepat tempo ketika menyanyikan bagian yang lebih ekspresif. Namun, lagu yang dihasilkan oleh AI ini tidak memiliki elemen itu. Nada-nada terdengar datar, seolah-olah AI hanya membaca teks tanpa memahami perasaan yang terkandung di dalamnya.

Sejalan dengan pendapat Baym (2018), AI dalam musik masih bekerja dengan pendekatan berbasis data dan pola statistik, sehingga sering kali kehilangan spontanitas dan improvisasi yang merupakan ciri khas ekspresi manusia dalam seni. Saya mulai berpikir: Jika AI bisa dilatih untuk mengenali pola improvisasi dalam musik daerah, mungkinkah suatu hari nanti AI bisa menghasilkan musik yang lebih natural dan ekspresif?

Pengembangan deep learning dalam musik berbasis AI memungkinkan model untuk lebih memahami elemen ekspresi dan improvisasi, tetapi tetap memerlukan campur tangan manusia agar musik yang dihasilkan tetap memiliki nuansa emosional yang otentik (Herremans et al. (2017).

Hasil Eksperimen Musik dan Video AI “Madura Blues”

Saya mencoba eksperimen ini lebih jauh; tidak hanya dalam bentuk musik, tetapi juga dalam bentuk video AI. Saya ingin melihat bagaimana AI tidak hanya menginterpretasikan lirik ke dalam musik, tetapi juga bagaimana menerjemahkan nuansa budaya Madura ke dalam visual yang dihasilkan oleh kecerdasan buatan.

Eksplorasi ini selaras dengan pandangan Elgammal et al. (2017) bahwa AI dapat menginterpretasikan elemen budaya dalam seni visual dengan mempelajari pola estetika dari dataset yang luas. Namun, seperti halnya dalam musik, tantangan utama dalam AI visual adalah menangkap ekspresi budaya yang unik dan tidak terdokumentasi dalam dataset yang umum digunakan oleh model AI.

AI dalam seni visual bekerja dengan pendekatan berbasis gaya, di mana sistem mengidentifikasi pola warna, bentuk, dan komposisi dari dataset yang ada (Manovich, 2020). Dalam kasus ini, visual AI yang dihasilkan dari “Madura Blues” mungkin tidak sepenuhnya merepresentasikan kekayaan visual budaya Madura karena keterbatasan dataset yang digunakan oleh AI.

Hasilnya? Saya mendapatkan visual klip AI yang mengiringi lagu “Madura Blues”, sebuah bentuk eksplorasi yang menggabungkan AI musik dan AI video dalam satu kesatuan karya.

Kendati mampu menghasilkan karya seni yang estetis, kata Boden (2016), namun AI Msuik belum mampu memahami makna yang mendalam dari budaya dan sejarah manusia yang terkandung dalam setiap karya seni tradisional. Ini membuat eksperimen ini menjadi sebuah tantangan menarik: apakah mungkin AI suatu hari nanti dapat benar-benar menangkap esensi budaya yang lebih kompleks?

AI dan Manusia dalam Harmoni

Setelah eksplorasi mendapat hasilnya, saya menutup laptop malam itu dengan perasaan yang campur aduk. Di satu sisi, saya kagum bahwa sebuah algoritma mampu menciptakan lagu hanya dari beberapa baris teks. Ini adalah revolusi yang membuka banyak kemungkinan. Namun, di sisi lain, saya juga menyadari bahwa musik bukan hanya tentang komposisi nada dan harmoni, tetapi juga tentang emosi, makna, dan sejarah yang tertanam dalam setiap melodi.

AI bisa membantu kita menciptakan musik, tetapi ia belum bisa menggantikan makna yang kita bawa dalam setiap nada yang kita mainkan. Musik adalah bahasa universal, dan kini, AI telah menjadi bagian dari perjalanannya. Tetapi, dalam perjalanan ini, kita tidak boleh melupakan peran manusia dalam menciptakan harmoni sejati.

Referensi

Agres, K. R., Schaefer, R. S., & Volk, A. (2019). Music and AI: The next big challenge. Frontiers in Psychology, 10, 401. https://doi.org/10.3389/fpsyg.2019.00401

Baym, N. K. (2018). Playing to the Crowd: Musicians, Audiences, and the Intimate Work of Connection. NYU Press.

Born, G., & Devine, K. (2015). Music technology, gender, and class: Digitization, educational and social change. Twentieth-Century Music, 12(2), 135-172.

Hesmondhalgh, D. (2013). Why Music Matters. Wiley-Blackwell.

Boden, M. A. (2004). The Creative Mind: Myths and Mechanisms. Routledge.

Cook, P. R. (2019). Music, Cognition, and Computerized Creativity. Springer.

Mazzola, G., Mannone, M., & Pang, Y. (2011). Cool Math for Hot Music: A First Introduction to Mathematics for Music Theorists. Springer.

Patel, A. D. (2010). Music, Language, and the Brain. Oxford University Press.

Sacks, O. (2007). Musicophilia: Tales of Music and the Brain. Alfred A. Knopf.

Cope, D. (2001). Virtual Music: Computer Synthesis of Musical Style. The MIT Press.

Herremans, D., Chuan, C.-H., & Chew, E. (2017). Deep learning for music generation: Challenges and directions. Neural Computing and Applications, 32(4), 977-993.

Patel, A. D. (2010). Music, Language, and the Brain. Oxford University Press.

Adams, O., Neubig, G., Cohn, T., & Bird, S. (2019). Massively multilingual neural machine translation: An effective strategy for low-resource languages. Transactions of the Association for Computational Linguistics, 7, 817-832.

Baym, N. K. (2018). Playing to the Crowd: Musicians, Audiences, and the Intimate Work of Connection. NYU Press.

Besacier, L., Barnard, E., Karpov, A., & Schultz, T. (2014). Automatic speech recognition for under-resourced languages: A survey. Speech Communication, 56, 85-100.

Dannenberg, R. B. (2017). Computational models of music performance. Music Perception, 34(1), 40-55.

Herremans, D., Chuan, C.-H., & Chew, E. (2017). Deep learning for music generation: Challenges and directions. Neural Computing and Applications, 32(4), 977-993.

Van den Oord, A., Dieleman, S., Zen, H., Simonyan, K., Vinyals, O., Graves, A., … & Kavukcuoglu, K. (2016). Wavenet: A generative model for raw audio. arXiv preprint arXiv:1609.03499.

Boden, M. A. (2016). AI: Its Nature and Future. Oxford University Press.

Elgammal, A., Liu, B., Elhoseiny, M., & Mazzone, M. (2017). CAN: Creative adversarial networks, generating “art” by learning about styles and deviating from style norms. arXiv preprint arXiv:1706.07068.

Manovich, L. (2020). AI Aesthetics. Strelka Press.